Neurociencias

Se pueden crear películas con los registros de la actividad neuronal

Sonidos de piano y violín acompañados de vídeo permiten comprender de manera más efectiva la complejidad cerebral

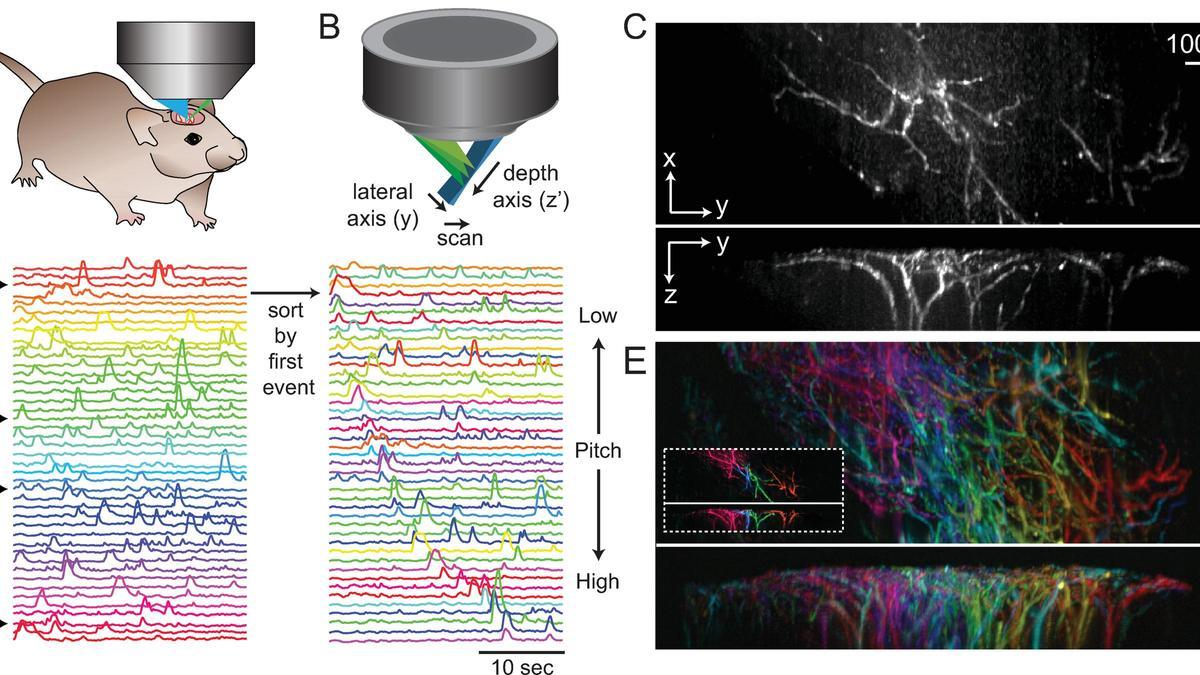

Audiovisualización de un conjunto de datos de microscopía SCAPE 4D. / David N. Thibodeaux et al. PLOS ONE.

Redacción T21

Una nueva metodología permite convertir datos complejos de neuroimágenes en formatos audiovisuales, lo que facilita el estudio en profundidad del cerebro y su relación con el comportamiento.

Un equipo de científicos, liderado por David Thibodeaux de la Universidad de Columbia en Estados Unidos, ha logrado transformar los datos de actividad neuronal y flujo sanguíneo en el cerebro de ratones en una combinación sincronizada de sonidos de piano y violín, acompañados de video.

Esta innovadora técnica no solo permite identificar patrones más fácilmente en grandes conjuntos de datos, sino que también mejora la comprensión de la relación dinámica entre la actividad neuronal y el comportamiento.

Herramienta versátil

Demostrado en diferentes configuraciones experimentales, incluyendo técnicas de imagen cerebral en 2D y 3D, este método proporciona una herramienta versátil para la exploración neurocientífica.

"Generalmente necesitas reproducir los clips una y otra vez para poder determinar lo que sucedió en un momento particular. Tener una representación auditiva de los datos facilita mucho ver (y escuchar) cuándo ocurren las cosas al mismo tiempo exacto", explica Charlotte Bhaskar, coautora del estudio publicado en la revista PLOS ONE.

Películas cerebrales

Esta novedosa herramienta, que ha sido descrita como la creación de hermosas "películas cerebrales", representa un avance significativo en la investigación neurocientífica.

Investigaciones anteriores habían demostrado que algunos datos de imágenes cerebrales pueden traducirse en representaciones audibles.

A partir de estos enfoques, Thibodeaux y sus colegas desarrollaron una nueva técnica en tres entornos experimentales diferentes, mostrando cómo se pueden preparar representaciones audiovisuales con datos de varios enfoques de imágenes cerebrales, incluido el mapeo óptico de campo amplio 2D (WFOM) y la microscopía de excitación plana alineada confocalmente barrida en 3D (SCAPE).

Sinfonía de piano y violín

El conjunto de herramientas se aplicó a datos de WFOM recopilados previamente que detectaron tanto la actividad neuronal como los cambios en el flujo sanguíneo cerebral en ratones que realizaban diferentes comportamientos, como correr o asearse.

Los datos neuronales estaban representados por sonidos de piano que golpeaban al mismo tiempo que picos en la actividad cerebral, donde el volumen de cada nota indicaba la magnitud de la actividad y su tono indicaba la ubicación en el cerebro donde se producía la actividad. Mientras tanto, los datos del flujo sanguíneo estuvieron representados por sonidos de violín.

Patrones ocultos

Los sonidos del piano y el violín, tocados en tiempo real, demuestran la relación acoplada entre la actividad neuronal y el flujo sanguíneo. Visto junto con un vídeo del ratón, el espectador puede discernir qué patrones de actividad cerebral correspondían a diferentes comportamientos.

Los autores señalan que su paquete de herramientas no sustituye al análisis cuantitativo de datos de neuroimagen. No obstante, podría ayudar a los científicos a detectar patrones que de otro modo podrían haber pasado desapercibidos y que merecen un análisis más detallado.

Nueva era neurocientífica

Con esta técnica, la neurociencia está entrando en una nueva era de exploración y comprensión, ya que, al transformar la actividad cerebral en una experiencia audiovisual, los investigadores pueden navegar por los misterios del cerebro con una perspectiva renovada y accesible.

La sinfonía cerebral no solo es una herramienta para los científicos, sino también una obra de arte que celebra la complejidad y la belleza del cerebro de los mamíferos.

Referencia

Audiovisualization of real-time neuroimaging data. David N. Thibodeaux et al. PLOS ONE, February 21, 2024. DOI:https://doi.org/10.1371/journal.pone.0297435

- Aprobado el nuevo tamaño de las maletas de mano: queda poco para que podamos viajar así

- Última hora sobre el subsidio para mayores de 52 años: todo lo que sabemos tras los últimos cambios

- Estas son las razones por las que tu gato quiere dormir contigo

- El dragado para "desatascar" la desembocadura del Segura en Guardamar retirará 193.000 toneladas de lodos

- La fruta de la belleza

- Cae el cártel de Sinaloa en España con la incautación de 1.800 kilos de "cristal" en Villena y Puçol

- Mil euros de multa por "aparcar" en la playa de Poniente de Benidorm

- El Barrio también quiere sacar tajada del turismo