Para poder explicar por qué una editora de tanto fuste en el concierto mundial de medios de comunicación como el grupo Springer ha firmado un acuerdo con OpenAI, creadora de ChatGPT, para permitirle que utilice sus contenidos en el entrenamiento de sus modelos de IA, habría que recuperar aquel viejo adagio clásico de la estrategia posibilista: “Si no puedes con tu enemigo, únete a él “. No es baladí el asunto porque Springer se descuelga de la guerra abierta que aún mantiene buen parte de la prensa mundial y otros creadores de contenidos por la utilización de materiales con derechos de autor en el entrenamiento de los LLM. Cuando un perro viejo como Mathias Döpfner hace ese movimiento es porque se está dando cuenta de que, diga lo que diga la IA Act europea, que establece la obligatoriedad (relativa) para los propietarios de los grandes modelos de IA Generativa de revelar con qué contenido protegido los entrenaron, esa puede ser una batalla legal de final incierto (el argumentario de las grandes empresas de IA que no ven delito en ese uso utiliza abogados de los mejores bufetes del mundo: aquí un ejemplo). Döpfner, el CEO y propietario del 22% de las acciones del emporio Springer, creado en Alemania con el Bild Zeitung o el Die Welt pero en el que tras su salto a EEUU con las compras de Bussines Insider y Politico ya no se pone el sol, fue uno de los primeros del sector a nivel mundial que tuvo claro hace tres lustros que el futuro de los medios de comunicación sería digital o no sería. Su olfato fue infalible entonces, por lo que hay que tener muy en cuenta esta apuesta actual. Un envite que seguramente tiene mucho que ver con que las IAG (Inteligencias Artificiales Generativas) empiezan a usurpar cada vez más a Google su papel hegemónico en la ordenación del contenido en la Red transformándose poco a poco en auténticos buscadores. En Springer habrán pensado que es preferible estar presentes en esas respuestas de ChatGPT, las citas a sus medios serán ahora obligadas para la IA de Sam Altman con este acuerdo, que seguir a merced de Google y su errática trayectoria de los últimos meses, que ha masacrado las audiencias de muchos medios y provocado pérdidas millonarias.

Google necesita cambiar desesperadamente para ponerse al nivel de sus competidores en el despliegue de la Inteligencia Artificial

Esa deriva de Google está más que justificada por el test de estrés al que ChatGPT le ha sometido desde que lanzó su IA hace poco más de un año. Hace tiempo que no era un secreto que el sistema de “SERP’s”, las páginas de resultados que el algoritmo de Google devolvía con cada búsqueda, eran un modelo en clara decadencia. Su transformación, según dicen los especialistas, puede acabar también con el sacrosanto sistema de optimización de las webs tejido en torno al SEO para aparecer lo más arriba posible en esas búsquedas, que tanto poder dio al buscador de Mountain View como dinero y tráfico a quienes lo utilizaron con destreza. No obstante, Google puede estar rezagado en el negocio de la IA, pero no ciego. Los precipitados cambios en el core de su algoritmo del buscador de los últimos cinco meses, tantos como en todo el lustro anterior, demuestran que Alphabet ya está “bailando”, como dijo el CEO de Microsoft, Satya Nadella, y no quiere quedarse atrás en esta carrera (algunos cifran ya en 30.000 millones de dólares las posibles pérdidas que le puede infligir no liderar el despliegue de la IA). De ahí la reacción brutal que se lleva por delante un sistema que le ha dado el liderazgo mundial y producido centenares de miles de millones de dólares de beneficio. Pero todo eso está ahora en riesgo, de ahí que en cuanto la “gran G” tenga Bard, potenciado por Gemini, su último y parece que brutal LLM, la página de búsquedas de Google ya no será lo mismo y su nuevo sistema, Search Generative Experience (SGE) se implantará en toda su crudeza. La IA generativa le permitirá prescindir primero de los enlaces a resultados, al elaborar un resumen que puede hacer innecesaria cualquier consulta posterior a otros enlaces, e individualizar después sus resultados de búsqueda en función de los perfiles que ha atesorado durante años estudiando nuestra forma de navegar (lo que la IA Act europea quiere controlar ahora). En ese nuevo paradigma “googeliano”, la autoridad de una web dependerá de la fidelidad de sus usuarios, no del ranking de Google como hasta ahora. Se parecerá más a una red social como las de Meta, Facebook o Instagram, que al buscador que era, algo que ya viene ensayando con Discover, su servicio de polémicas recomendaciones de temas y noticias para los móviles de Android, desde hace unos años. Todo ello configura un brutal cambio en el statu quo de la Red, tal y como la hemos conocido hasta ahora, con el fin del SEO como evangelio del marketing online y, por ende, el declive, no se sabe si definitivo, de las audiencias millonarias venidas de ámbitos lejanos que tantos ingresos en publicidad programática reportaban a quienes practicaban esa optimización para tener contento a Google. Algo que quita el sueño en la mayoría de los medios de comunicación.

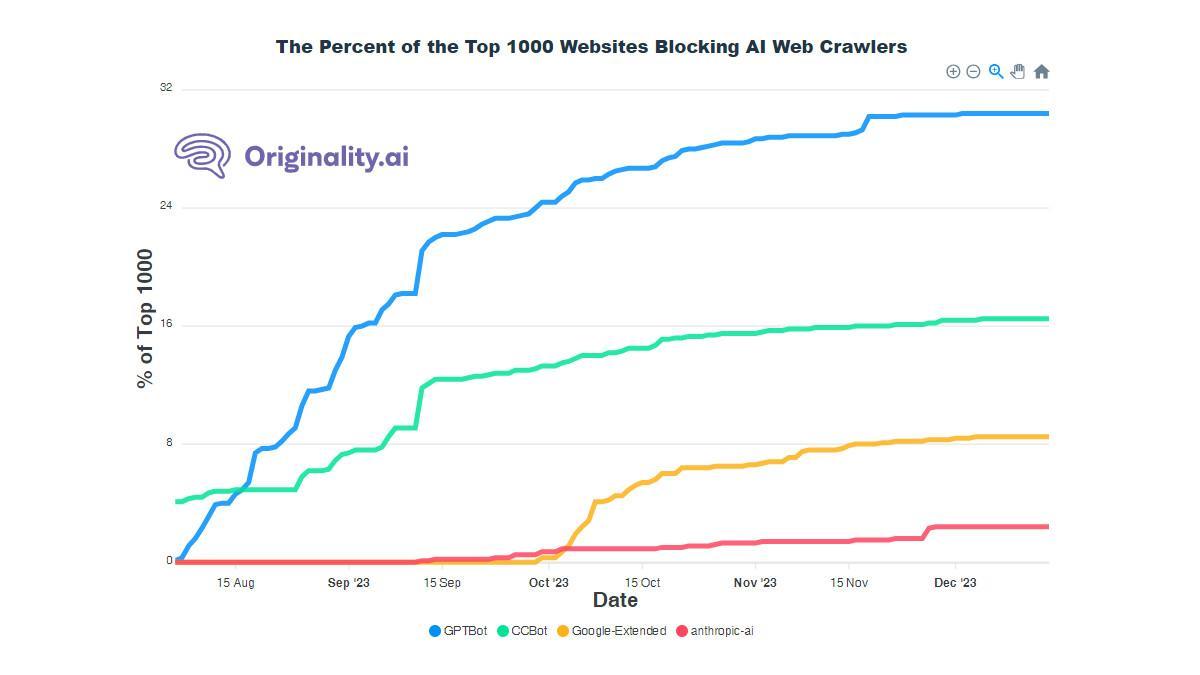

Por otro lado, el movimiento de Springer no puede esconder que también OpenAI necesitaba despejar nubarrones del horizonte en dos sentidos. El primero, minimizar el posible aluvión de recursos judiciales (aquí se puede ver un ejemplo de las demandas que ha recibido, solo en EEUU) y, segundo, evitar que cada vez se le cierren más puertas de proveedores de contenidos. Las IA aún requieren de billones de datos para seguir entrenando sus modelos, algo que se le estaba poniendo más difícil a los de Sam Altman en los últimos tiempos. Desde que se lanzó en el pasado mes de agosto GPTBot, un rastreador (crawler) que “blanquea” la entrada por las bravas en las webs ofreciendo a sus propietarios la posibilidad de bloquear el acceso, (antes entraba sin dar esa opción, “raspaba” (scraping) de forma inmisericorde las webs y se llevaba todo lo que encontraba a su paso sin que nadie se enterara), cada vez son más los dan un portazo. Aunque ahora llaman educadamente, al “crawler” de OpenAI ya le están diciendo que no un 30% de las 1.000 primeras webs del mundo por tráfico, muchas de ellas medios de comunicación. El bloqueo también se ha hecho extensivo a los robots de Common Crawl, al parecer el cooperador necesario que le abrió las puertas a Altman de 100 millones de webs; Google-Extended, el “robot” de la AI de Alphabet, y el de Anthropic, el infatigable “crawler” de la IA “Claude”, de los hermanos Amodei, antiguos miembros de OpenAI que cuentan con dinero en su proyecto de Google y Amazon, nada menos. No es extraño por otro lado que en esta lista de “rastreadores non gratos” Google tenga cuatro veces menos puertas cerradas que OpenAI. Google-Extended, el robot específico para IA, se anunció hace apenas tres meses. Esto quiere decir que hasta hace tres meses había que tener nervios de acero y alma de boina verde para cerrar la puerta de tu web al rastreador único del líder mundial con un 90% de la cuota de mercado de búsquedas, que podía hacer, con mano invisible, que te fuera muy bien o que podía hundirte en la más absoluta de las miserias, sin que en ninguno de ambos casos la responsabilidad fuera suya. Aún hoy, sigue dando miedo.

En el gráfico de originality.ai, una web que se dedica a buscar contenido plagiado e identificar el que han hecho las IA’s, se puede ver cómo cada vez más las puertas se cerraban para las Inteligencias Artificiales. Sin datos, ya lo hemos dicho aquí alguna vez, la IA’s lo pierden todo. La reacción era previsible, aunque aún hay inmensos recursos en la web, dominados por autores que desconocen su inmenso valor actual, que no ponen pegas a su utilización. ¡Todo por la causa de la IA!