Uno de los conceptos más comprometidos de la Inteligencia Artificial actual y su dependencia del entrenamiento con redes neuronales artificiales que imitan las redes físicas de nuestro cerebro es el de la “caja negra”. Un problema que en el año anterior no han sido aún capaces de resolver las grandes empresas que participan en la intensa carrera por liderar esta tecnología. Básicamente, cuando hablamos de “black box” estamos refiriéndonos a un enigma: durante el entrenamiento de una inteligencia artificial sabemos el “input” y el “output” del sistema, los datos que entran y los resultados que salen, pero no sabemos cómo se produce este proceso ni cómo la IA ha llegado a las conclusiones que llega. Hay otros especialistas que consideran que el “black box” es un mito porque el problema no está en que el sistema sea opaco, sino que no se han desarrollado suficientemente las herramientas para interpretar su funcionamiento interno. De todas formas, si el mismísimo CEO de Google, Sundar Pichai, dice en una entrevista al prestigioso programa televisivo “60 minutes” que algo pasa ahí dentro “que no entiendes del todo”, debe ser que las claves están aún lejos de ser entendidas.

Y conocer esas claves del proceso interno de una Inteligencia Artificial no es un tema precisamente menor. Sin una transparencia absoluta sobre el camino que la IA ha recorrido para alcanzar el lugar al que llega se desencadena una crisis de confianza importante. Si además los temas sobre los que la IA debe aportar respuestas son tan delicados como la medicina, el derecho o el medio ambiente, la inquietud se dispara. Dicho de otra forma: el comportamiento actual de la IA recuerda en cierto modo a los tiempos pretéritos de la Humanidad en los que nos fiábamos del chamán y de su magia, que por supuesto no entendíamos aunque sus resultados fueran alentadores, más que a una era de ciencia y razón como la nuestra.

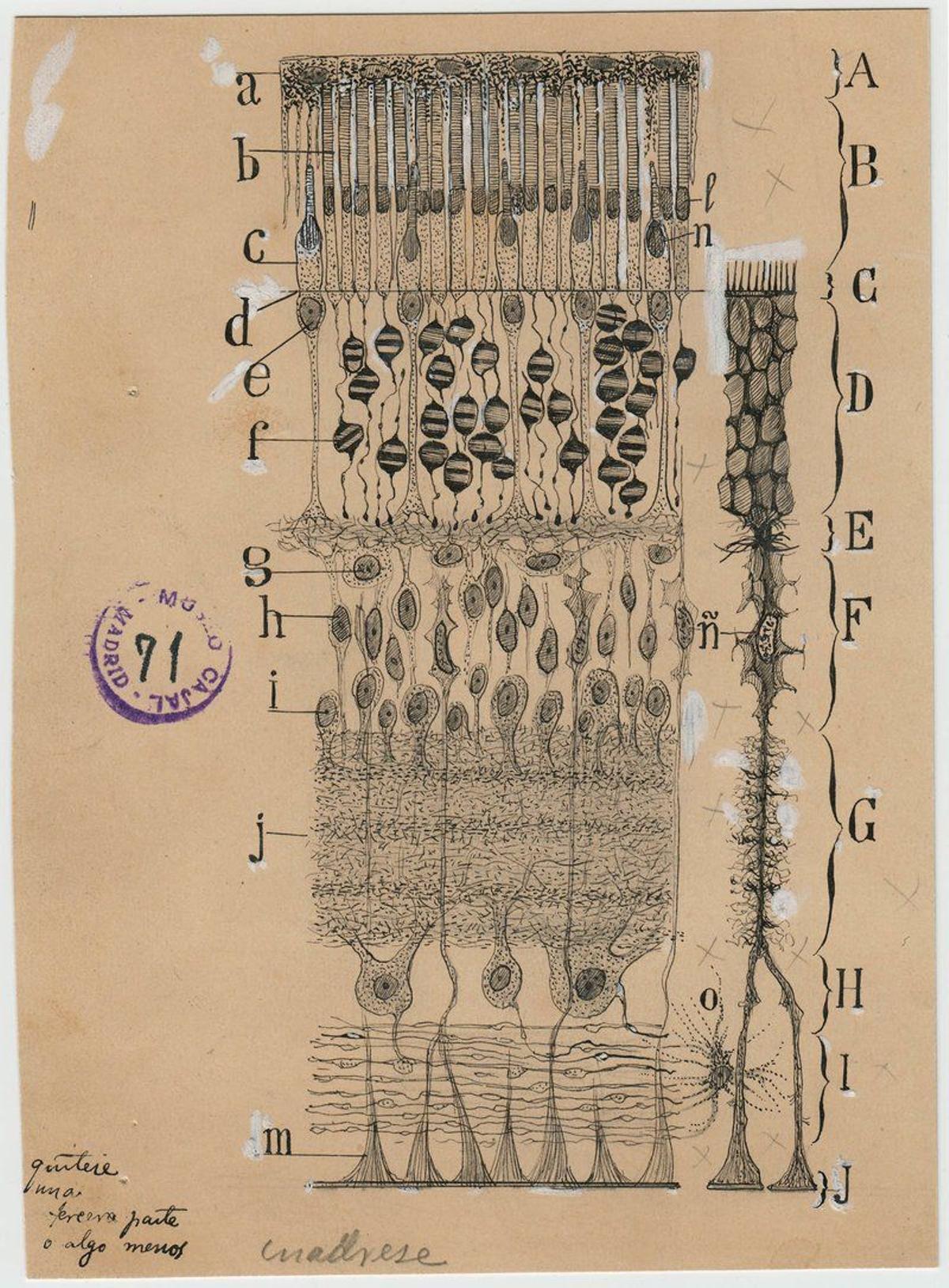

Realmente, si lo pensamos un poco, tampoco es raro que pase esto. Las redes neuronales son un algoritmo del llamado “aprendizaje automático”, lo que hacen los sistemas informáticos capaces de aprender por sí mismos, que copia el comportamiento de los cerebros biológicos. Precisemos, porque lo correcto sería decir “que copia lo que sabemos del comportamiento del cerebro físico”. Neuronas artificiales intentan organizarse por capas como lo hacen las biológicas, en un proceso que, por cierto, descubrió hace más de 130 años ese genio olvidado de la ciencia patria llamado Santiago Ramón y Cajal. La cantidad de capas es tal y el proceso tiene tal complejidad, generando por cierto un gasto energético descomunal, que puede ser difícil, cuando no imposible, rastrear los pasos dados y la toma de decisiones consiguiente. Es como si el "juego de imitación" de Turing hubiera mutado a su vez en una sarcástica paradoja: la IA ha avanzado copiando el enigma que nuestro cerebro aún es para los científicos. El problema es que ha arrastrado esos enigmas, las “cajas negras” del cerebro original, creando a su vez una nueva caja negra, tan incomprensible como la de la “materia gris” real. Pura poesía de lo indescifrable.

El común de los mortales nos hemos acostumbrado a vivir con tecnologías que funcionan y que no entendemos cómo lo hacen. Y a esta circunstancia no son ajenos los propios informáticos, que tienen que aprender este concepto de “caja negra”, no aplicable solo a la IA, en sus primeros años en la universidad: puede haber un módulo, objeto o componente que deberán utilizar sin conocer su funcionamiento interno. Pero si tampoco nuestros sumos sacerdotes de la Inteligencia Artificial lo entienden al ciento por ciento, algo empieza a ir preocupantemente mal. Sobre todo cuando esta situación no se debe únicamente a lo complejo que es entrar en esa “caja negra” para descubrir sus secretos, sino a que las prisas y los intereses creados, que diría Benavente, han convertido la evolución de la IA en una alocada huida hacia adelante en la que importa más el resultado que el análisis del proceso. Ya sea porque es imposible entenderlo o porque es mío y no quiero que nadie rebusque para destripar el misterio: ahí las empresas que crean la IA sí creen en los derechos de autor. Mientras tanto, en Estados Unidos, la Administración ha autorizado ya 581 modelos de IA implicados en decisiones médicas, muchos de los cuales han sido entrenados con esas cajas negras que no entendemos del todo aún cómo funcionan.

La buena noticia es que el avance tecnológico y científico no tarda en crear cortafuegos para esas situaciones. Ya hay investigadores de la IA que se están especializando en lo que se denomina “interpretabilidad” y que básicamente persigue convertir esa caja negra en un recipiente totalmente transparente. Un concepto que acompaña a otro, la “explicabilidad”, una especie de “cómo se hace” de los algoritmos, para el que incluso los bancos empiezan a proveerte de material.

"El aprendizaje automático fue diseñado para ser una caja negra: modelos predictivos que son demasiado complicados"

La norteamericana Cynthia Rudin es una de esos investigadores. En una interesante entrevista de la revista Quantamagazine señala la raíz del problema: el aprendizaje automático que hace posible que ChatGPT genere aceptables poemas fue diseñado para ser una “caja negra”. Rudin dice que “Son modelos predictivos demasiado complicados para que cualquier ser humano los entienda. O son propiedades, la “salsa secreta” de alguien. La idea inicial es que no era necesario lidiar con los datos, sino que el algoritmo se encargaría de todo eso bajo el capó. Era muy elegante como concepto, pero hacía que fuera difícil entender qué estaba pasando”. Rudin sabe de lo que habla porque, como dice el refrán, fue cocinera antes que fraile. Tras graduarse, trabajó con la compañía eléctrica de Nueva York en crear un modelo de IA que predijera las alcantarillas más susceptibles de sufrir incendios o explosiones, una “rareza” que afectaba nada menos al 1% de los conductos del subsuelo de Manhattan. Al elaborar el modelo trabajaron con muchos datos, que sistematizaron. Pese a ello, el modelo incluyó un dato sobre “cables neutros” que alteraba todo el resultado final. Al saber qué contenía dentro el modelo, la compañía eléctrica pudo darse cuenta de que eso no debía estar ahí y el problema pudo solventarse. Si no, hubiera sido un desastre. “Es realmente difícil solucionar problemas de modelos si no sabes qué contienen”, le dice Rudin a la periodista de Quantamagazine.

La cuestión es que entrenar en un modo “interpretable” es mucho más lento y por tanto mucho más caro: hay que asegurarse de cómo va a “razonar” (las comillas son necesarias) la IA para asegurarse de que las conclusiones son correctas. En decisiones de alto riesgo esto parece obligado. Sin embargo, no parece pasar nada si la IA utiliza su enorme habilidad para calcular probabilidades en decidir a quién le coloca una publicidad de zapatillas deportivas en internet y a quién no. Sobre todo si el sistema funciona… Nadie va a preocuparse de que todo lo controle un modelo tipo “caja negra”.

El problema es precisamente ese: aceptar un resultado sin saber de dónde viene o sin poder discutir por qué es así. Ni ChatGPT, ni Bard ni ninguna otra IA Generativa son oráculos o dioses a los que no se les pueda poner en cuestión. Fredric Brown, uno de los grandes escritores de ciencia ficción, glosó magníficamente los riesgos de esa actitud en un delicioso cuento corto escrito en 1954 titulado “Respuesta”, en el que alguien tiene el privilegio de hacer la primera pregunta al mayor ordenador de la historia. La pregunta es (¿acaso podía ser otra?): “¿Hay un Dios?” Imagínense lo que respondió.